首页 - 资讯 - 火爆全网!AI新星Groq横空出世,真的能碾压英伟达GPU?

| 2024-02-21

火爆AI圈,刷屏互联网!

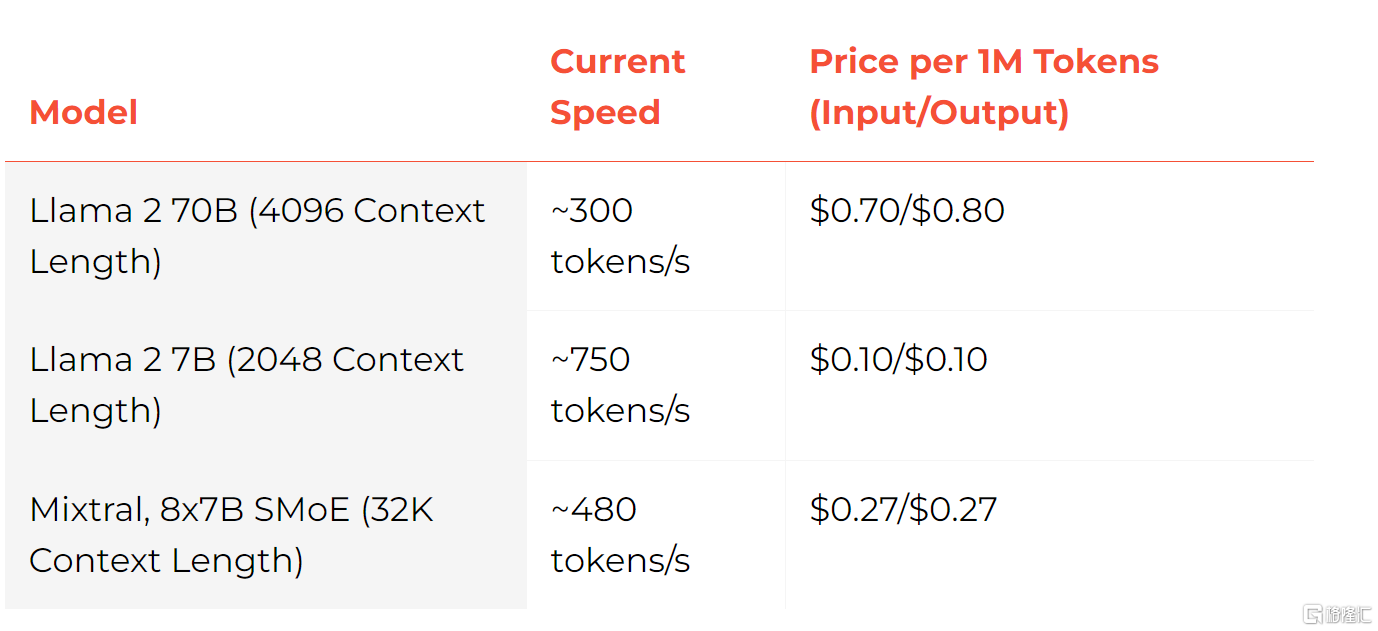

近期,Groq引发广泛讨论,其大模型每秒能输出750个tokens,比GPT-3.5快18倍,自研LPU推理速度是英伟达GPU的10倍。

Groq名字与马斯克的大模型Grok读音类似,成立于2016年,定位为一家人工智能解决方案公司。

Groq爆火主要是因为其处理速度非常快。据媒体报道,该公司的芯片推理速度较英伟达GPU提高10倍,成本只有其1/10。

运行的大模型生成速度接近每秒500 tokens,碾压ChatGPT-3.5大约40 tokens/秒的速度。

极限情况下,Groq的Llama2 7B甚至能实现每秒750 tokens,为GPT-3.5的18倍。

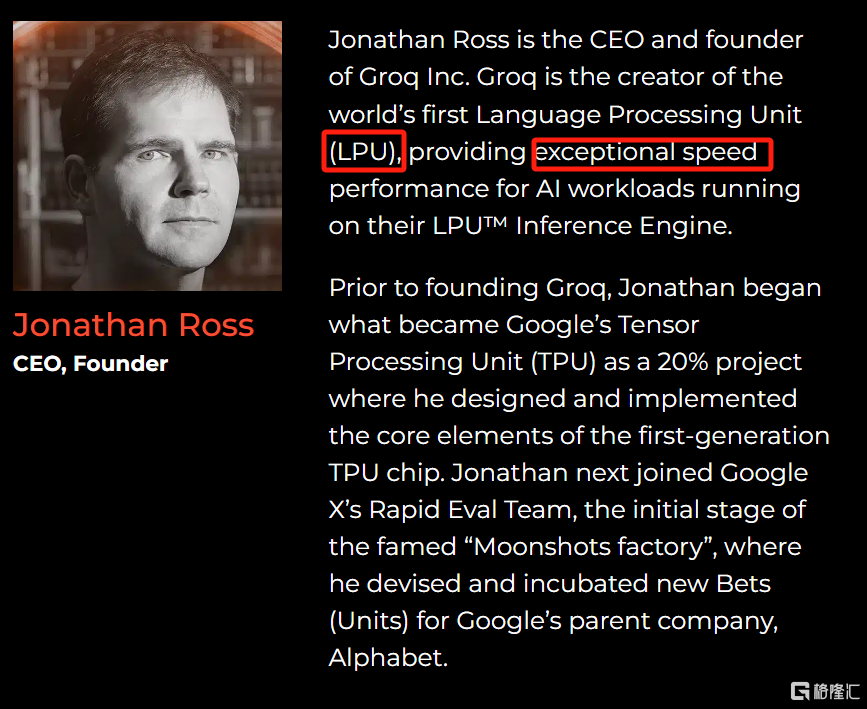

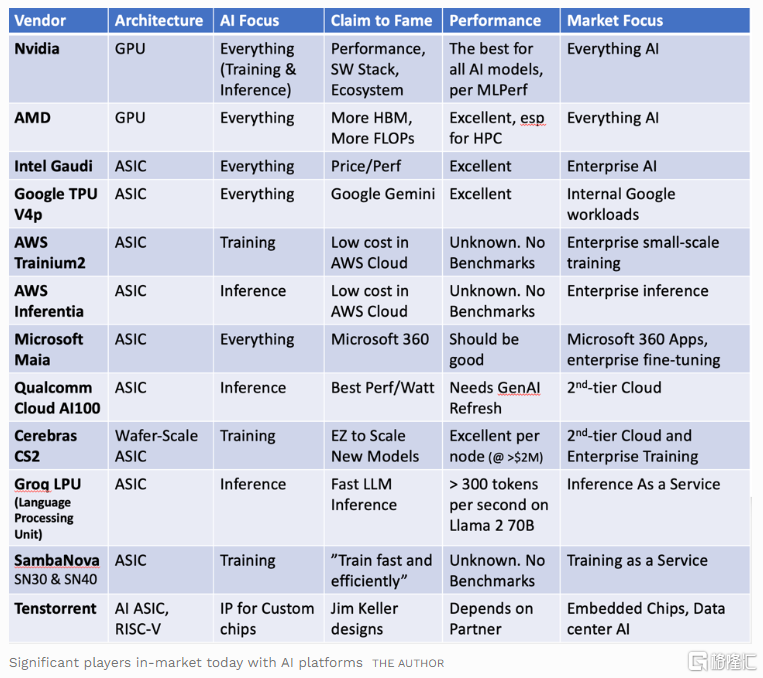

在Groq的创始团队中,有8人来自谷歌早期TPU核心设计团队,但Groq并未选择TPU、GPU、CPU等路线,而是自研了语言处理单元(LPU)。

Groq官网显示,在 Groq LPU™推理引擎上运行的Meta AI的Llama 2 70B的性能优于所有其他基于云的推理提供商,吞吐量提高了18倍。

不过,速度并不是AI发展的唯一决定性因素。在Groq爆火的同时,也有一些质疑声音。

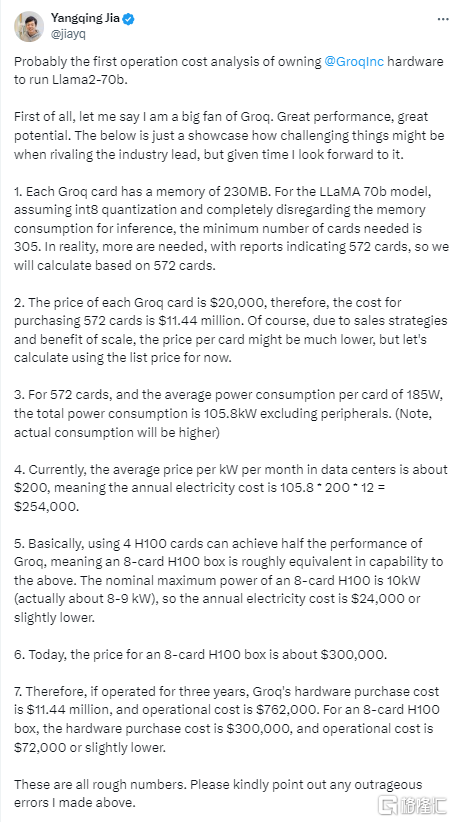

首先,Groq似乎只是看起来了便宜。Groq的一张LPU卡仅有230MB的内存,售价为2万多美元。

据业内专家贾清扬分析,假设LLaMA 70b模型需要572张Groq卡进行计算,如果运营三年,Groq 的硬件采购成本为1144万美元,运营成本(耗电等)为762000 美元。而英伟达的8卡H100就能实现相当的性能,硬件采购成本为30万美元,运营成本为72000美元或略低。

更为关键的是,Groq LPU完全不配备高带宽存储器(HBM),而是仅配备了一小块的超高速静态随机存取存储器(SRAM),这种SRAM的速度比HBM3快20倍。

这也意味着,与英伟达的H200相比,在运行单个AI模型时需要配置更多的Groq LPU。

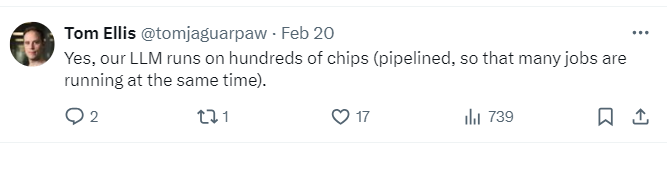

另据Groq员工透露,Groq的LLM在数百个芯片上运行。

对此,腾讯科技的芯片专家姚金鑫认为,Groq的芯片目前并不能取代英伟达。

他认为,速度是Groq的双刃剑。Groq的架构建立在小内存、大算力上,因此有限的被处理的内容对应着极高的算力,导致其速度非常快。

另一方面,Groq极高的速度是建立在很有限的单卡吞吐能力上的,要保证和H100同样吞吐量,就需要更多的卡。

他分析,对于Groq这种架构来讲,也有其尽显长处的应用场景,对许多需要频繁数据搬运的场景来说再好不过。

我已同意并阅读 《隐私声明》和《使用条款》